大數據時代的高速發展推動互聯網、大數據、云計算、人工智能、區塊鏈等技術日益創新,金融、互聯網、運營商、政府等數據密集型行業的數據存儲量呈現爆發性增長的趨勢,如何從海量數據中幫助企業更好管理和挖掘業務數據價值,滿足企業業務快速發展的需求,成為大數據數倉應用的重要方向。

大數據數倉通常采用分布式計算技術,利用大數據天然的擴展性來完成海量數據的存放,同時把SQL轉換成針對大數據計算引擎的任務,實現數據分析,如Hadoop、Spark等作為存儲和計算引擎,使用工具或編程語言設計處理邏輯,實現對不同數據源的匯聚、清洗、計算和分析。除此之外,大數據數倉還具有面向海量數據、可高效查詢和分析、具備數據安全性以及靈活性等特點。

在國內,本地部署模式的數據倉庫仍是目前政府、金融、能源以及大型企業的首選。固態硬盤憑借其高吞吐量、低時延等特征逐漸成為大數據時代下數據存儲的重要載體,是當前本地部署的數據倉庫產品重要搭載硬件。

為更好應對數據密集型行業對高性能、高可靠存儲的需求,憶聯特聯合國內大數據倉儲的佼佼者——南大通用(下稱:GBase)共同探索大數據時代下數字化轉型存儲新方案。

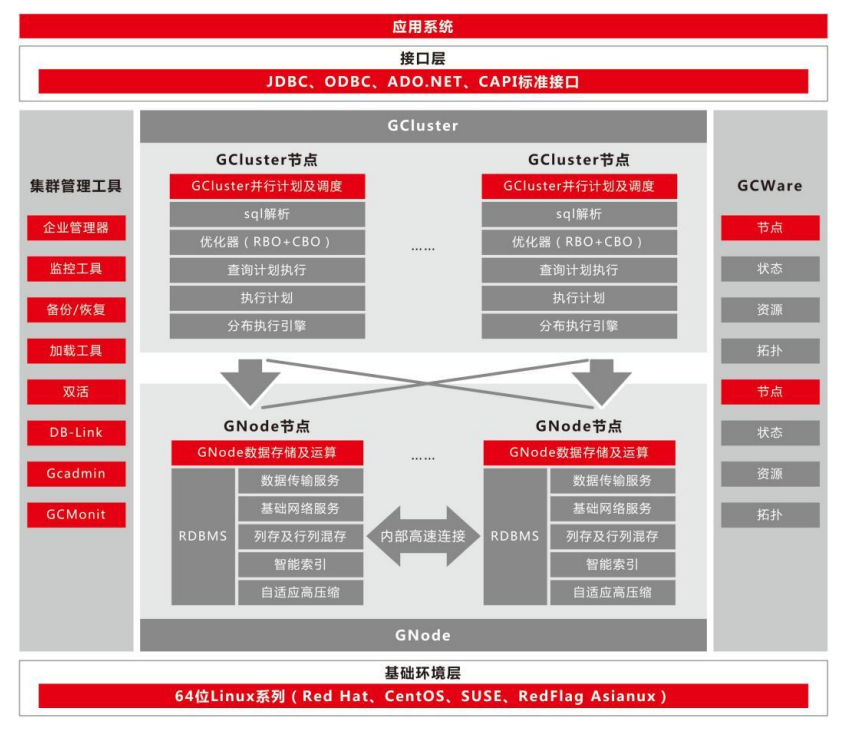

南大通用大規模分布式并行數據庫集群系統(簡稱GBase 8a MPP Cluster),是在GBase 8a系列存儲數據庫基礎上開發的一款Shared Nothing 架構的分布式并行數據庫集群,具備高性能、高可用、高擴展等特性,可為各種規模數據管理提供高性價比的通用計算平臺,廣泛用于支撐各類數據倉庫系統、BI系統和決策支持系統。

圖1:GBase 8a MPP Cluster技術架構圖

GBase 8a MPP Cluster采用MPP+Shared Nothing的分布式聯邦架構,節點間通過 TCP/IP網絡進行通信,每個節點采用本地磁盤來存儲數據。GBase 8a MPP Cluster系統中的每一個節點都是相對獨立的、自給的,整個系統具有非常強的擴展性,可從幾個節點擴展到上百節點,滿足業務規模增長的要求。

1 驗證環境

1.1 本次驗證硬件配置

|

類型 |

型號 |

硬件配置 |

備注 |

|

服務器 |

2U2路(X86) |

CPU:Intel? Xeon? Gold 6330 CPU@2.00GHz*2 |

3臺 |

|

內存:8*32GB |

|||

|

存儲控制器:支持RAID 5(數據盤) |

|||

|

網卡:1*2端口10GE以太網卡 |

|||

|

硬盤 |

憶聯SSD |

系統盤:2*480GB SATA SSD 數據盤:6*3.84TB SAS SSD(UM511a) |

|

|

交換機 |

10GE 交換機 |

48端口10GE交換機 |

/ |

1.2 本次驗證軟件配置

|

類型 |

型號 |

版本 |

備注 |

|

操作系統 |

redhat(x86) |

7.9 |

/ |

|

GBase版本 |

GBase 8a |

GBase8a_MPP_Cluster-License-9.5.3.14 |

/ |

|

客戶端 |

gccli |

9.5.3.14 |

/ |

|

數據庫壓測 |

TPC-DS |

3.2.0rc1 |

開源 |

|

數據庫壓測 |

TPC-H |

3.0.0 |

開源 |

|

網絡監控 |

SAR |

10.1.5 |

OS自帶 |

|

IOSTAT |

盤側IO統計 |

10.0.0 |

/ |

|

MPSTAT |

CPU利用 |

10.1.5 |

/ |

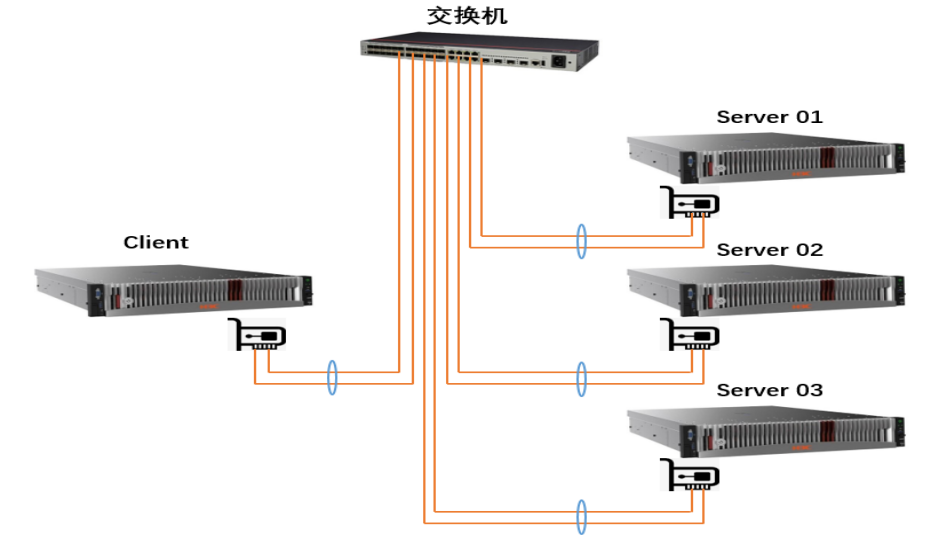

1.3 本次驗證組網規劃

圖2:本次GBase 8a MPP組網規劃架構圖

2 驗證方法

步驟1:將6塊SAS UM511a配置Raid5。

步驟2:創建數據庫和表

? 使用TPC-H工具評估數據庫分析處理能力,需要提前創建數據庫和TPC-H內置的8張表;

? 使用TPC-DS工具評估數據庫分析處理能力,提前創建數據庫和TPC-DS內置的25張表。

步驟3:參數調優

根據GBase建議進行相關參數調優。

步驟4:數據生成

? TCH-H通過dbgen工具可以通過設置參數生成所需的測試數據,命令參數為/dbgen -C 10 -S 1 -s 3000 –vf;

? TPC-DS通過dsdgen工具可以通過設置參數生成所需的測試數據,命令參數為./dsdgen -scale 3000 -dir testdata -force -parallel 10 -child 1。

步驟5:數據加載

? 數據導入時,在GBASE集群本地節點搭建FTP服務器,通過FTP加載數據。當一個表包含多個數據文件時,將單表的多個數據文件集成一個導入語句中,以單表為粒度分別加載測試數據至8張數據庫表中。

步驟6:SQL執行

? 獨立的客戶端,通過業務平面網絡與GBase集群通信,使用gccli工具執行TPC-H 22個SQL用例,參考命令為/home/GBase/gccli_install/gcluster/server/bin/gccli -h 10.28.100.38 -uroot -Dtpch -vvv < query_1.sql。

3 驗證結果

本次在GBase 8a MPP場景下驗證結果如下:

3.1憶聯SAS SSD在Raid邏輯卷帶寬性能測試下的表現

圖3:憶聯SAS盤在Raid邏輯卷帶寬性能測試下的表現

在本次測試中,將6個SAS SSD配置Raid5,12塊SATA配置Raid50,在Server主機使用FIO測試工具進行128KB順序讀寫帶寬性能壓測。從圖3結果表現可知,SAS SSD讀寫帶寬更優,讀帶寬比SATA有19.6% 左右提升,寫帶寬提升34% 左右,展現了SAS SSD在Raid邏輯卷帶寬下的絕對優勢。

3.2憶聯SAS SSD在單盤故障降級&重構讀性能下的表現

圖4:憶聯SAS SSD在單盤故障降級&重構讀性能下的表現

單盤降級讀性能是指RAID組在單盤故障或拔出情況下的RAID組邏輯卷讀業務性能,重構性能是指但盤故障后,RAID同時進行熱備盤數據重構和業務下發時的業務側性能。本次通過將6塊憶聯SAS SSD配置Raid5后,在一塊SSD故障條件下進行測試。

如圖4所示,不管是在單盤降級讀性能還是在重構讀帶寬條件下,SAS盤的表現都優于SATA,單盤降級讀性能優于SATA 22.7% 左右,重構讀帶寬性能上比SATA最大有38.4% 左右的提升。

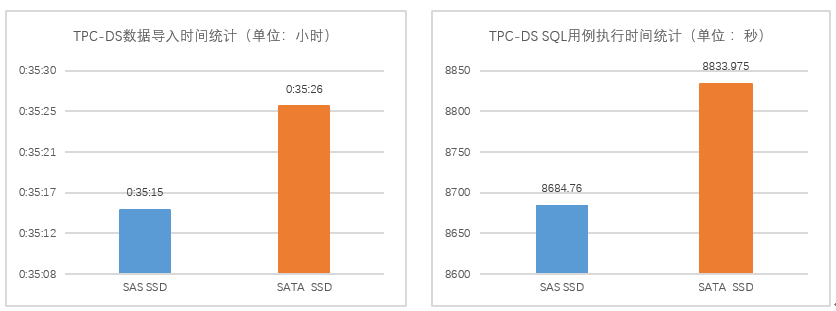

3.3憶聯SAS SSD在TPC-DS場景下的表現

圖5:TPC-DS場景下憶聯SAS SSD的表現

TPC-DS測試是通過FTP協議加載數據到GBase數據庫表。從圖5可見,在相同物理硬件環境下,SAS SSD不管是在數據導入還是在SQL用例執行時間上所用時間都略低于SATA SSD,具備一定時間優勢。

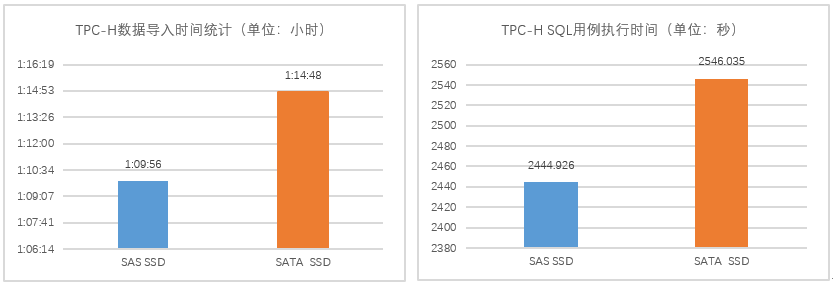

3.4 憶聯SAS SSD在TCP-H場景下的表現

圖6: TPC-H場景下憶聯SAS SSD的表現

TPC-H測試是通過FTP協議加載數據到GBase數據庫表。圖6展現了SAS SSD以及SATA SSD在TPC-H測試下的表現,其中SAS SSD總用時略優于SATA SSD ,數據導入時間優于SATA約6% ,對SQL用例執行時間上相比SATA SSD降低了3% 左右。

本次驗證可充分體現憶聯SAS SSD 在GBase 8a MPP場景下的性能優勢,SAS SSD可有效支持業務高效開展,具備單盤帶寬更高,盤故障重構、降級性能更優等優勢,不僅可以幫助企業節約硬件采購成本,也可解決海量數據下的大數據存儲和計算問題,高效處理海量結構化數據。

憶聯深耕固態硬盤領域多年,已發布多款高性能、高可靠產品,具備應對復雜的業務環境和數據庫挑戰的能力,可滿足行業用戶海量數據處理需求。憶聯將持續聯合GBase共同打造數字化轉型背景下的存儲新方案。

地址:深圳市南山區記憶科技后海中心B座19樓

電話:0755-2681 3300

郵箱:support@unionmem.com